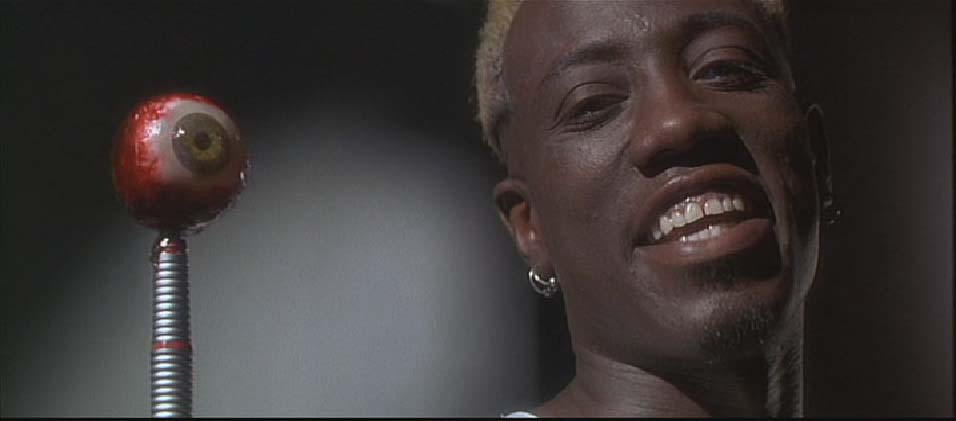

Нейросети могут быть опасными: сгенерированные лица и синтезированные голоса все более реалистичны

Технология машинного обучения, нейросети - все это стало уже давно привычным во многих отраслях науки, технологий, медицины и других сфер. В том, что они могут быть очень полезными, нет никаких сомнений. Но есть и обратная сторона медали - использование возможностей современных технологий для обмана.

Если раньше киберпреступники массово рассылали фишинговые письма, то сейчас уже известны случаи, когда они же пытаются подделать голос руководителя компании для достижения своих целей. Мы уже писали о трендах в киберзащите, связанных с искусственным интеллектом, и проблема фейковых голосов и лиц - одна из них. Подробнее - под катом.

Читать далееИсточник: Хабрахабр

💬 Комментарии

В связи с новыми требованиями законодательства РФ (ФЗ-152, ФЗ «О рекламе») и ужесточением контроля со стороны РКН, мы отключили систему комментариев на сайте.

🔒 Важно Теперь мы не собираем и не храним ваши персональные данные — даже если очень захотим.

💡 Хотите обсудить материал?

Присоединяйтесь к нашему Telegram-каналу:

https://t.me/blogssmartzНажмите кнопку ниже — и вы сразу попадёте в чат с комментариями